— Par Marie Vabre —

— Par Marie Vabre —

Digne d’un roman de George Orwell, Donald Trump mène chaque jour une guerre dystopique contre la science – mais pas seulement : détentions ou expulsions de scientifiques et d’étudiant·es, licenciements en masse, intimidations, censures, gels de financements, entraves à la collaboration scientifique internationale, etc. Aucune discipline n’est épargnée : études de la diversité et sciences sociales, du climat et de l’environnement, recherche médicale en santé publique… Les enquêtes menées actuellement sur plus de 50 universités sont délétères.

L’administration Trump s’en prend à tous les postes et les organes perçus comme des opposants, considérant que leur travail va à l’encontre de son idéologie, son agenda conservateur et ses intérêts financiers. “La nouveauté, c’est la vitesse et l’intensité. En trois mois à peine, on assiste à une mise sous pression qui dépasse largement le précédent mandat“, observe Virginie Adane, maîtresse de conférences en histoire moderne à Nantes Université.

Le SOS des scientifiques états-uniens

De nombreux organismes de recherche et de régulation ont subi les attaques violentes du DOGE, le département de l’efficacité gouvernementale d’Elon Musk.

—

— — Par Gilles Bonnet(*) —

— Par Gilles Bonnet(*) — Mentalo est une application qui permet de participer à une étude d’envergure sur la santé mentale des jeunes de 11 à 24 ans. Les résultats de cette enquête menée par l’Inserm ont pour but d’identifier les facteurs qui favorisent ou dégradent le bien-être mental des personnes entrant dans cette tranche d’âge.

Mentalo est une application qui permet de participer à une étude d’envergure sur la santé mentale des jeunes de 11 à 24 ans. Les résultats de cette enquête menée par l’Inserm ont pour but d’identifier les facteurs qui favorisent ou dégradent le bien-être mental des personnes entrant dans cette tranche d’âge. — Par Pascal Froissart(*) —

— Par Pascal Froissart(*) — Le 28 décembre 2024 marque un tournant pour les consommateurs européens : le chargeur universel USB-C devient la norme pour les appareils électroniques. Cette initiative, issue d’une directive européenne adoptée en 2022, vise à simplifier le quotidien des utilisateurs tout en réduisant les déchets électroniques. Dès ce samedi, tous les nouveaux smartphones, tablettes, liseuses, casques, appareils photos, et autres gadgets devront être compatibles avec un chargeur USB-C. Seuls les ordinateurs portables, dont la réglementation entrera en vigueur en 2026, échappent pour l’instant à cette obligation.

Le 28 décembre 2024 marque un tournant pour les consommateurs européens : le chargeur universel USB-C devient la norme pour les appareils électroniques. Cette initiative, issue d’une directive européenne adoptée en 2022, vise à simplifier le quotidien des utilisateurs tout en réduisant les déchets électroniques. Dès ce samedi, tous les nouveaux smartphones, tablettes, liseuses, casques, appareils photos, et autres gadgets devront être compatibles avec un chargeur USB-C. Seuls les ordinateurs portables, dont la réglementation entrera en vigueur en 2026, échappent pour l’instant à cette obligation.

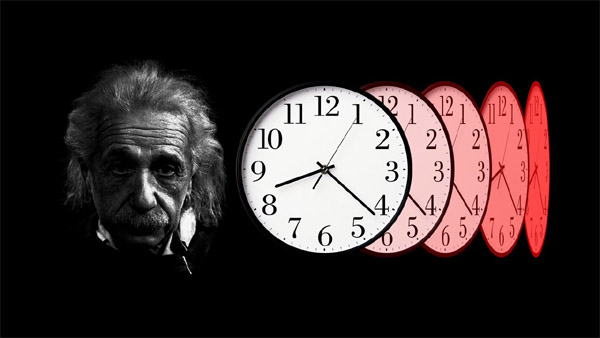

La relativité restreinte est la théorie élaborée par Albert Einstein en 1905 en vue de tirer toutes les conséquences physiques de la relativité galiléenne et du principe selon lequel la vitesse de la lumière dans le vide a la même valeur dans tous les référentiels galiléens (ou inertiels), ce qui était implicitement énoncé dans les équations de Maxwell (mais interprété bien différemment jusque-là, avec « l’espace absolu » de Newton et l’éther).

La relativité restreinte est la théorie élaborée par Albert Einstein en 1905 en vue de tirer toutes les conséquences physiques de la relativité galiléenne et du principe selon lequel la vitesse de la lumière dans le vide a la même valeur dans tous les référentiels galiléens (ou inertiels), ce qui était implicitement énoncé dans les équations de Maxwell (mais interprété bien différemment jusque-là, avec « l’espace absolu » de Newton et l’éther).

Vous souhaitez connaître les tarifs du contrôle technique des centres près de chez vous ou dans un autre département en France ? Consultez le nouveau site vous informant sur le prix des contrôles techniques. Il vous permet de trouver un centre agréé grâce à d

Vous souhaitez connaître les tarifs du contrôle technique des centres près de chez vous ou dans un autre département en France ? Consultez le nouveau site vous informant sur le prix des contrôles techniques. Il vous permet de trouver un centre agréé grâce à d — Par Martin Van Waerebeke &

— Par Martin Van Waerebeke &  Le 23 avril, le Premier ministre Gabriel Attal a annoncé vouloir réhumaniser le service public grâce à l’intelligence artificielle, ce qui constitue un tournant sans précédent. Si pour lutter

Le 23 avril, le Premier ministre Gabriel Attal a annoncé vouloir réhumaniser le service public grâce à l’intelligence artificielle, ce qui constitue un tournant sans précédent. Si pour lutter Vous avez gagné un jeu-concours auquel vous n’avez jamais participé, une fausse urgence vous invite à rappeler un numéro, vous devez renouveler une démarche administrative que vous n’avez jamais commencée… Il peut s’agir d’une tentative frauduleuse vous forçant à rappeler un numéro surtaxé. On fait le point sur ces numéros spéciaux, leur tarification et comment signaler d’éventuels abus.

Vous avez gagné un jeu-concours auquel vous n’avez jamais participé, une fausse urgence vous invite à rappeler un numéro, vous devez renouveler une démarche administrative que vous n’avez jamais commencée… Il peut s’agir d’une tentative frauduleuse vous forçant à rappeler un numéro surtaxé. On fait le point sur ces numéros spéciaux, leur tarification et comment signaler d’éventuels abus. Swarovski Optik a révolutionné le monde de l’ornithologie en dévoilant ses jumelles AX Vision lors du CES 2024. Ces jumelles, boostées à l’intelligence artificielle, sont équipées d’une technologie avancée permettant d’identifier près de 9000 espèces d’oiseaux en moins de cinq secondes. Une prouesse technologique qui a séduit les passionnés de la nature lors de cet événement à Las Vegas.

Swarovski Optik a révolutionné le monde de l’ornithologie en dévoilant ses jumelles AX Vision lors du CES 2024. Ces jumelles, boostées à l’intelligence artificielle, sont équipées d’une technologie avancée permettant d’identifier près de 9000 espèces d’oiseaux en moins de cinq secondes. Une prouesse technologique qui a séduit les passionnés de la nature lors de cet événement à Las Vegas.

Le régulateur européen de la protection des données (EDPB) a ordonné à l’Irlande, où se trouve le siège européen de Meta, d’appliquer l’interdiction du recours aux données privées à des fins publicitaires. Cette décision, applicable sous deux semaines, intervient alors que le géant technologique américain a annoncé proposer des formules d’abonnement payantes à ses utilisateurs européens qui ne souhaitent pas voir leurs données utilisées, justement en vue de se conformer aux réglementations de l’UE. Le régulateur norvégien des données avait enjoint mi-juillet à Meta de cesser de recueillir, sans consentement explicite, les données des utilisateurs de Facebook et Instagram dans le but de leur adresser des publicités ciblées, et lui impose depuis mi-août une amende quotidienne. Le Comité européen de la protection des données a adopté vendredi 27 octobre “une décision urgente et contraignante” pour étendre cette interdiction aux trente pays de l’Espace économique européen (les 27 Etats membres de l’UE, Norvège, Islande, Liechtenstein). Cette pratique, qui consiste à utiliser les données personnelles des internautes pour leur soumettre des publicités ciblées, est jugée contrevenir au règlement européen sur les données (RGPD).

Le régulateur européen de la protection des données (EDPB) a ordonné à l’Irlande, où se trouve le siège européen de Meta, d’appliquer l’interdiction du recours aux données privées à des fins publicitaires. Cette décision, applicable sous deux semaines, intervient alors que le géant technologique américain a annoncé proposer des formules d’abonnement payantes à ses utilisateurs européens qui ne souhaitent pas voir leurs données utilisées, justement en vue de se conformer aux réglementations de l’UE. Le régulateur norvégien des données avait enjoint mi-juillet à Meta de cesser de recueillir, sans consentement explicite, les données des utilisateurs de Facebook et Instagram dans le but de leur adresser des publicités ciblées, et lui impose depuis mi-août une amende quotidienne. Le Comité européen de la protection des données a adopté vendredi 27 octobre “une décision urgente et contraignante” pour étendre cette interdiction aux trente pays de l’Espace économique européen (les 27 Etats membres de l’UE, Norvège, Islande, Liechtenstein). Cette pratique, qui consiste à utiliser les données personnelles des internautes pour leur soumettre des publicités ciblées, est jugée contrevenir au règlement européen sur les données (RGPD). L’industrie du jeu vidéo a connu une évolution significative en France ces dernières années, marquée par une féminisation croissante des équipes de production. En 2022, près d’un salarié sur quatre (24%) travaillant dans les équipes de production des studios français de jeux vidéo était une femme, selon une étude publiée par le Syndicat National du Jeu Vidéo (SNJV). Cette proportion est en hausse de dix points par rapport à quatre ans plus tôt, démontrant une tendance forte et continue vers la diversification du secteur.

L’industrie du jeu vidéo a connu une évolution significative en France ces dernières années, marquée par une féminisation croissante des équipes de production. En 2022, près d’un salarié sur quatre (24%) travaillant dans les équipes de production des studios français de jeux vidéo était une femme, selon une étude publiée par le Syndicat National du Jeu Vidéo (SNJV). Cette proportion est en hausse de dix points par rapport à quatre ans plus tôt, démontrant une tendance forte et continue vers la diversification du secteur. Pour récupérer de l’énergie renouvelable, les

Pour récupérer de l’énergie renouvelable, les